워크플로우 자동화의 새로운 전환점: 내장 데이터베이스가 바꾸는 업무 효율

자동화 도구에 내장된 데이터베이스 기능이 등장하면서, 복잡한 외부 연동 없이도 빠르고 안정적인 데이터 관리가 가능해졌습니다. 인증 설정의 번거로움을 없애고, 처리 속도를 대폭 개선하는 이 기술이 실무에서 어떻게 활용될 수 있는지 구체적인 사례와 함께 알아봅니다.

자동화 시스템의 숨은 병목: 데이터 저장소 연동

워크플로우 자동화를 구축하다 보면 반드시 마주치는 순간이 있습니다. "이 데이터를 어디에 저장하지?" 대부분은 구글 시트, 에어테이블, 혹은 PostgreSQL 같은 외부 데이터베이스를 연결합니다. 그런데 이 과정이 생각보다 까다롭습니다.

왜 외부 데이터베이스 연동이 번거로울까요?

마치 집에서 요리를 하는데 식재료를 매번 이웃집 냉장고에서 빌려와야 하는 상황과 같습니다. 음식을 만들 때마다 문을 두드리고, 열쇠를 받고, 냉장고를 열어야 하죠. 자동화 시스템도 마찬가지입니다:

- 인증 설정의 복잡성: OAuth 설정, API 키 발급, 권한 관리 등 초기 설정에만 상당한 시간이 소요됩니다

- 토큰 만료 문제: 인증 토큰이 주기적으로 만료되어 재인증이 필요합니다

- API 호출 지연: 외부 서비스와 통신하는 시간이 누적되면 전체 워크플로우가 느려집니다

- 의존성 리스크: 외부 서비스에 장애가 발생하면 전체 시스템이 멈춥니다

최근 주요 자동화 플랫폼들이 이 문제를 해결하기 위해 내장형 데이터베이스 기능을 도입하고 있습니다. 이는 단순한 기능 추가가 아니라, 자동화 시스템 설계 방식 자체를 바꾸는 전환점입니다.

내장 데이터베이스가 해결하는 세 가지 핵심 문제

1. 인증 없는 즉시 사용 (Zero-Configuration)

전통적인 방식에서는 데이터베이스를 사용하기 전에 복잡한 준비 과정을 거쳐야 했습니다:

기존 방식의 단계:

- 외부 서비스 계정 생성

- API 키 또는 OAuth 앱 설정

- 권한 및 스코프 구성

- 자동화 도구에 인증 정보 입력

- 연결 테스트 및 문제 해결

내장 데이터베이스 방식:

- 데이터베이스 생성 버튼 클릭

- 즉시 사용 시작

실제로 셀프 호스팅 환경에서 구글 시트를 연동하려면 구글 클라우드 콘솔에서 OAuth 2.0 클라이언트를 생성하고, 리디렉션 URL을 설정하고, 스코프를 지정하는 등 최소 15분 이상의 설정 시간이 필요합니다. 내장 데이터베이스는 이 모든 과정을 생략합니다.

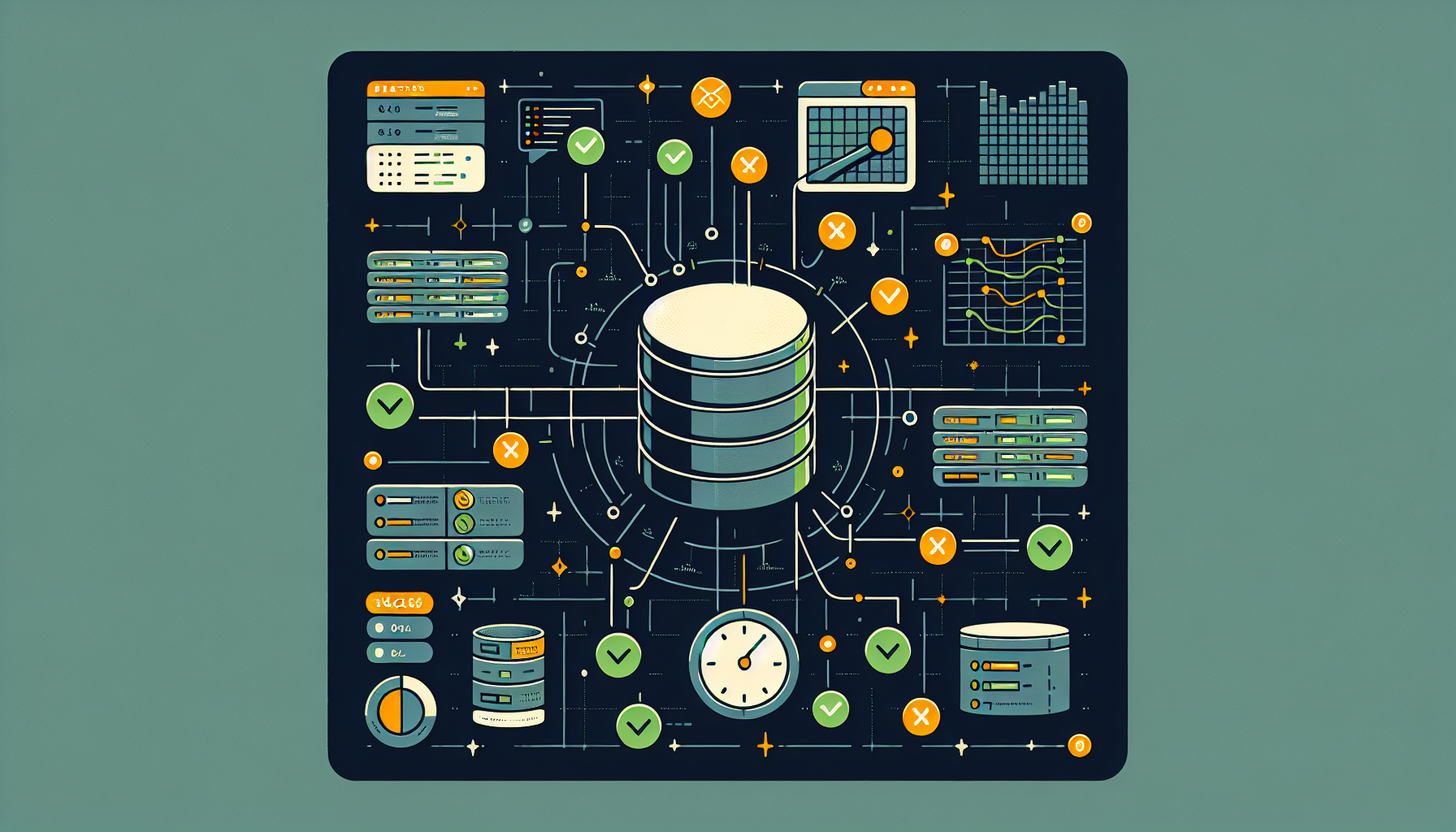

2. 극적인 속도 개선

속도 비교 실험 결과 (5개 행 데이터 삽입 기준):

| 저장소 유형 | 처리 시간 | 속도 비율 |

|---|---|---|

| 구글 시트 | 3,456ms | 기준 |

| 내장 데이터베이스 | 7ms | **약 494배 빠름** |

왜 이렇게 큰 차이가 날까요?

외부 데이터베이스 처리 과정:

워크플로우 → 네트워크 요청 → 외부 서버 인증 → 데이터 처리 → 응답 전송 → 워크플로우

내장 데이터베이스 처리 과정:

워크플로우 → 로컬 데이터베이스 쿼리 → 워크플로우

네트워크 왕복 시간(RTT, Round Trip Time)과 외부 서버의 처리 대기 시간이 완전히 제거되는 것입니다. 특히 소량의 데이터를 자주 읽고 쓰는 작업에서 이 차이는 더욱 두드러집니다.

3. 여러 워크플로우 간 데이터 공유

내장 데이터베이스는 플랫폼 내부에 존재하기 때문에, 서로 다른 워크플로우들이 동일한 데이터 저장소를 공유할 수 있습니다. 이는 마치 여러 앱이 같은 클라우드 저장소를 사용하는 것과 유사합니다.

실무 활용 시나리오:

- 워크플로우 A: 고객 이메일을 수집하여 데이터베이스에 저장

- 워크플로우 B: 저장된 이메일 목록을 읽어 주간 뉴스레터 발송

- 워크플로우 C: 동일한 데이터베이스를 조회하여 중복 가입 방지

외부 데이터베이스도 이런 공유가 가능하지만, 각 워크플로우마다 인증을 설정해야 하는 번거로움이 있습니다. 내장 데이터베이스는 이 과정이 자동으로 처리됩니다.

실무 활용법 1: 중복 제거 자동화 시스템

뉴스레터를 운영한다고 가정해봅시다. 랜딩 페이지에서 구독 신청을 받을 때, 같은 이메일이 여러 번 등록되는 것을 방지해야 합니다.

시스템 구조 설계

데이터베이스 스키마:

| 컬럼명 | 데이터 타입 | 설명 |

|---|---|---|

| id | 자동 생성 | 고유 식별자 |

| 문자열 | 구독자 이메일 | |

| source | 문자열 | 유입 경로 (예: 랜딩페이지, 블로그) |

| created_at | 타임스탬프 | 등록 시각 |

| updated_at | 타임스탬프 | 수정 시각 |

워크플로우 로직

1단계: 웹훅으로 데이터 수신

- 랜딩 페이지의 "구독하기" 버튼 클릭 시 POST 요청 발생

- 요청 본문(body)에 이메일, 소스, 타임스탬프 포함

2단계: 중복 확인

IF (데이터베이스에 해당 이메일이 존재하는가?)

→ YES: 프로세스 종료 (중복 방지)

→ NO: 3단계로 진행

3단계: 신규 데이터 저장

- 데이터베이스에 새로운 행(row) 추가

- 이메일, 소스, 타임스탬프 저장

핵심 구현 포인트

중복 확인 방법: "존재하지 않을 때만 실행" 조건 사용

- 기존 방식: 전체 데이터를 조회 → 비교 → 판단 (느림)

- 최적화 방식: 데이터베이스의 조건부 쿼리 활용 (빠름)

실제 처리 속도:

- 웹훅 수신부터 데이터베이스 저장까지 평균 10~20ms

- 외부 시트를 사용할 경우 1,000~3,000ms

이 시스템은 하루에 수천 건의 구독 신청을 처리해도 병목 현상 없이 안정적으로 작동합니다.

실무 활용법 2: 실시간 로그 수집 시스템

복잡한 자동화 시스템을 운영하다 보면 "어느 단계에서 오류가 발생했는지", "처리 시간이 얼마나 걸렸는지" 추적해야 할 때가 있습니다. 내장 데이터베이스는 이런 로그 데이터를 실시간으로 기록하는 데 이상적입니다.

로그 데이터베이스 설계

필수 컬럼 구성:

| 컬럼명 | 용도 | 예시 값 |

|---|---|---|

| workflow_id | 워크플로우 식별 | "newsletter_system" |

| execution_id | 실행 세션 ID | "exec_20240115_001" |

| step_name | 처리 단계 | "validate_email" |

| status | 실행 결과 | "success" / "failed" / "skipped" |

| duration_ms | 소요 시간 (밀리초) | 45 |

| error_message | 오류 내용 | "Invalid email format" |

| timestamp | 기록 시각 | "2024-01-15 14:30:22" |

로그 기록 전략

1. 시작 로그 (Start Log)

{

step_name: "check_duplicate",

status: "started",

input_data: { email: "user@example.com" },

timestamp: new Date().toISOString()

}

2. 중간 로그 (Skip Log)

- 중복 데이터 감지 시: "duplicate_detected"

- 조건 불충족 시: "condition_not_met"

3. 완료 로그 (Complete Log)

{

step_name: "insert_subscriber",

status: "completed",

duration_ms: 12,

result: "1 row inserted",

timestamp: new Date().toISOString()

}

로그 분석의 실무적 가치

문제 상황: 특정 시간대에 구독 신청이 처리되지 않는 오류 발생

로그 기반 진단 과정:

- 데이터베이스에서 해당 시간대 로그 조회

status = "failed"필터링error_message확인 → "API rate limit exceeded" 발견- 외부 API 호출 빈도 조절로 문제 해결

로그가 없었다면 이 문제를 찾기 위해 전체 워크플로우를 수동으로 테스트해야 했을 것입니다. 내장 데이터베이스의 빠른 쓰기 속도 덕분에 모든 단계를 실시간으로 기록해도 성능 저하가 거의 없습니다.

로그 보관 정책

단기 로그 (7일 보관):

- 모든 실행 단계의 상세 로그

- 디버깅 및 즉각적인 문제 해결용

장기 로그 (90일 보관):

- 오류 로그만 선별 보관

- 통계 및 패턴 분석용

주기적으로 오래된 로그를 삭제하거나 외부 저장소로 아카이빙하는 자동화 워크플로우를 구성하면 데이터베이스 크기를 관리할 수 있습니다.

실무 활용법 3: AI 프롬프트 중앙 관리 시스템

AI를 활용한 자동화가 늘어나면서 새로운 문제가 생겼습니다. 여러 워크플로우에서 유사한 AI 작업을 수행하는데, 각각의 프롬프트를 개별적으로 관리하면 다음과 같은 비효율이 발생합니다:

- 프롬프트 개선 시 모든 워크플로우를 일일이 수정해야 함

- 어떤 워크플로우에 어떤 프롬프트가 적용되었는지 추적 어려움

- A/B 테스트나 버전 관리가 사실상 불가능

내장 데이터베이스를 프롬프트 템플릿 저장소로 활용하면 이 문제를 해결할 수 있습니다.

프롬프트 템플릿 데이터베이스 구조

| 컬럼명 | 설명 | 예시 |

|---|---|---|

| template_key | 템플릿 식별자 | "rss_summary_v1" |

| model | AI 모델명 | "gpt-4o-mini" |

| system_prompt | 시스템 역할 정의 | "당신은 기술 뉴스 요약 전문가입니다" |

| user_prompt | 사용자 지시사항 | "다음 RSS 피드를 3줄로 요약하세요: {{input}}" |

| version | 버전 번호 | "1.2" |

| created_at | 생성일 | "2024-01-10" |

| is_active | 활성화 여부 | true |

템플릿 기반 워크플로우 구성

기존 방식 (비효율적):

RSS 피드 수집 → AI 노드 (프롬프트 직접 입력) → 슬랙 전송

템플릿 방식 (효율적):

RSS 피드 수집 → 템플릿 조회 ("rss_summary_v1") → AI 노드 (템플릿 적용) → 슬랙 전송

구체적인 구현 예시

1단계: 템플릿 조회

- 데이터베이스에서

template_key = "rss_summary_v1"조건으로 검색 - 해당하는 모델명, 시스템 프롬프트, 유저 프롬프트 가져오기

2단계: AI 노드에 동적 적용

// 하드코딩 방식 (X)

model: "gpt-4o-mini"

system_prompt: "당신은..."

// 템플릿 방식 (O)

model: {{$node["Get_Template"].json["model"]}}

system_prompt: {{$node["Get_Template"].json["system_prompt"]}}

3단계: 변수 치환

유저 프롬프트에 {{input}}과 같은 플레이스홀더가 있다면, 실제 데이터로 치환:

user_prompt = template.user_prompt.replace('{{input}}', rss_content)

프롬프트 버전 관리 전략

시나리오: RSS 뉴스 요약의 품질을 개선하고 싶음

A/B 테스트 방법:

- 데이터베이스에 "rss_summary_v2" 템플릿 추가

- 일부 워크플로우만 v2로 변경 (template_key만 수정)

- 양쪽 결과를 비교하여 더 나은 버전 선택

- 전체 워크플로우에 승자 템플릿 적용

롤백 시나리오: 새 프롬프트가 예상과 다르게 작동

- 데이터베이스에서 해당 템플릿의

is_active를 false로 변경 - 이전 버전의

is_active를 true로 변경 - 모든 워크플로우가 자동으로 이전 버전 사용

실제 적용 사례

상황: 5개의 워크플로우에서 동일한 "기술 뉴스 요약" AI 작업 수행

개선 전:

- 프롬프트 수정 시 5개 워크플로우 개별 편집 필요 (약 15분 소요)

- 어떤 워크플로우에 최신 프롬프트가 적용되었는지 불명확

개선 후:

- 데이터베이스에서 템플릿 1회 수정 (약 1분 소요)

- 모든 워크플로우에 즉시 반영

- 버전 이력이 데이터베이스에 자동 기록

이 방식은 특히 프롬프트 엔지니어링을 지속적으로 개선하는 팀에게 유용합니다. 실험적인 프롬프트를 빠르게 테스트하고, 효과가 검증되면 전체 시스템에 적용하는 사이클을 단축할 수 있습니다.

내장 데이터베이스 도입 시 고려사항

장점 요약

✅ 즉시 사용 가능: 인증 설정 불필요, 클릭 몇 번으로 생성

✅ 압도적인 속도: 네트워크 지연 제거로 최대 수백 배 빠름

✅ 워크플로우 간 공유: 중앙 집중식 데이터 관리

✅ 안정성: 외부 서비스 장애로부터 독립적

✅ 비용 효율: 별도의 데이터베이스 구독료 불필요

제한사항 및 대안

1. 데이터 타입 제약

- 현재 지원: 문자열(String), 숫자(Number), 불린(Boolean), 날짜(Date/Time)

- 미지원: JSON 객체, 배열, 파일 첨부

- 대안: 복잡한 데이터는 JSON 문자열로 직렬화하여 저장

2. 쿼리 기능 한계

- 고급 SQL 쿼리(JOIN, 집계 함수 등) 미지원

- 대안: 복잡한 분석은 데이터를 외부 DB로 주기적으로 동기화

3. 데이터 용량 제한

- 플랫폼마다 다르지만, 일반적으로 수백 MB ~ 수 GB 수준

- 대안: 대용량 데이터는 외부 저장소 사용, 내장 DB는 메타데이터만 관리

4. 백업 및 복구

- 자동 백업 기능이 제한적일 수 있음

- 대안: 중요 데이터는 주기적으로 외부 저장소로 내보내기 워크플로우 구성

언제 외부 데이터베이스를 사용해야 할까?

내장 데이터베이스가 적합한 경우:

- 워크플로우 실행 로그, 임시 데이터, 설정값 저장

- 빠른 읽기/쓰기가 필요한 소규모 데이터 (수천~수만 행)

- 자동화 시스템 내부에서만 사용하는 데이터

외부 데이터베이스가 필요한 경우:

- 다른 애플리케이션과 데이터를 공유해야 할 때

- 복잡한 관계형 쿼리나 집계 분석이 필요할 때

- 수백만 행 이상의 대용량 데이터 처리

- 법적 요구사항으로 특정 데이터 저장 위치를 지정해야 할 때

하이브리드 전략 (권장):

- 내장 DB: 워크플로우 제어, 로그, 캐시, 템플릿

- 외부 DB: 비즈니스 핵심 데이터, 장기 보관 데이터, 분석용 데이터

마이그레이션 가이드: 기존 시스템에서 전환하기

이미 구글 시트나 에어테이블로 구축된 시스템이 있다면, 다음 단계로 점진적으로 전환할 수 있습니다.

1단계: 성능 병목 구간 파악

워크플로우 실행 로그를 분석하여 가장 시간이 오래 걸리는 데이터베이스 작업을 찾습니다.

확인 방법:

- 각 노드의 실행 시간 측정

- 1,000ms 이상 소요되는 데이터베이스 작업 리스트업

2단계: 우선순위 결정

다음 기준으로 마이그레이션 우선순위를 정합니다:

| 우선순위 | 조건 | 예시 |

|---|---|---|

| 높음 | 실행 빈도 높음 + 속도 느림 | 실시간 중복 체크 |

| 중간 | 외부 공유 불필요 + 소규모 데이터 | 설정값, 템플릿 |

| 낮음 | 외부 앱과 연동 필요 | 고객 주문 데이터 |

3단계: 병렬 운영 테스트

기존 외부 DB와 내장 DB를 동시에 사용하면서 결과를 비교합니다.

웹훅 수신

↓

├→ 기존 시트에 저장 (검증용)

└→ 내장 DB에 저장 (실제 사용)

일정 기간(예: 1주일) 동안 데이터 일치 여부를 확인한 후, 문제가 없으면 기존 시스템 제거합니다.

4단계: 데이터 마이그레이션

기존 데이터를 내장 DB로 이전하는 워크플로우를 만듭니다.

마이그레이션 워크플로우 구조:

- 외부 DB에서 모든 행 조회 (페이지네이션 사용)

- 각 행을 내장 DB 형식으로 변환

- 배치 삽입 (한 번에 100~500행씩)

- 오류 발생 시 로그 기록 및 재시도

주의사항:

- 대용량 데이터는 야간에 마이그레이션 실행

- 마이그레이션 중에도 기존 시스템은 계속 작동하도록 구성

- 마이그레이션 완료 후 데이터 건수 및 샘플 데이터 검증

핵심 정리

✅ 내장 데이터베이스는 복잡한 인증 설정 없이 즉시 사용 가능하며, 외부 API 호출을 제거하여 최대 수백 배 빠른 처리 속도를 제공합니다.

✅ 실시간 중복 제거 시스템을 구축하면 뉴스레터 구독, 회원가입 등에서 중복 데이터를 자동으로 차단하고, 신규 데이터만 빠르게 저장할 수 있습니다.

✅ 로그 수집 시스템을 통해 워크플로우의 각 단계를 실시간으로 추적하고, 오류 발생 시 신속하게 원인을 파악하여 시스템 안정성을 높일 수 있습니다.

✅ AI 프롬프트 중앙 관리를 구현하면 여러 워크플로우에서 사용하는 프롬프트를 한 곳에서 관리하고, 버전 관리 및 A/B 테스트를 효율적으로 수행할 수 있습니다.

✅ 하이브리드 전략을 통해 내장 데이터베이스는 빠른 처리가 필요한 작업에, 외부 데이터베이스는 장기 보관 및 복잡한 분석 작업에 활용하면 최적의 시스템을 구축할 수 있습니다.