AI 에이전트 성능, 이제 숫자로 증명하세요 — 체계적 평가와 개선 전략

AI 에이전트를 만들었지만 실제 품질을 어떻게 측정할까요? 감이 아닌 데이터 기반 평가로 AI 시스템의 성능을 객관적으로 검증하고, 지속적으로 개선하는 실전 방법을 알아봅니다.

AI 시스템, 감으로 만들면 안 되는 이유

여러분이 업무 자동화를 위해 AI 에이전트를 구축했다고 가정해봅시다. 이메일을 자동 분류하거나, 고객 문의에 답변하거나, 문서에서 정보를 추출하는 시스템을 만들었죠. 그런데 한 가지 중요한 질문이 남습니다.

"이 시스템, 제대로 작동하고 있는 걸까요?"

많은 사람들이 AI 에이전트를 만든 후 "대충 잘 되는 것 같은데?"라는 느낌만으로 운영을 시작합니다. 하지만 이런 접근은 세 가지 심각한 문제를 초래합니다.

감에 의존할 때 발생하는 3가지 위험

1. 현재 성능을 정확히 알 수 없습니다

마치 계기판 없는 자동차를 운전하는 것과 같습니다. 지금 시속 50km로 가는지 150km로 가는지 알 수 없죠. AI 시스템도 마찬가지입니다. 정확도가 60%인지 95%인지 모르면, 실무에 적용해도 되는지 판단할 수 없습니다.

2. 개선 효과를 측정할 수 없습니다

프롬프트를 수정하거나 AI 모델을 바꿨을 때, 실제로 나아진 건지 나빠진 건지 알 수 없습니다. "뭔가 더 좋아진 것 같기도 하고..."라는 추측만 가능할 뿐이죠. 이는 개선 작업을 무의미하게 만듭니다.

3. 시간 경과에 따른 품질 변화를 감지할 수 없습니다

처음엔 잘 작동하던 시스템이 데이터가 쌓이면서 성능이 저하될 수 있습니다. 하지만 측정 지표가 없으면 이런 변화를 눈치채기 어렵습니다. 문제가 심각해진 후에야 뒤늦게 발견하게 되죠.

AI 시스템 평가, 어떻게 시작할까?

다행히 AI 시스템 성능을 체계적으로 평가하는 방법이 있습니다. 크게 두 가지 접근법으로 나뉩니다.

1. 사람이 직접 평가하기

해당 분야 전문가가 AI의 입력과 출력을 일일이 검토하는 방식입니다. 예를 들어 의료 AI라면 의사가, 법률 AI라면 변호사가 결과물을 평가하는 거죠.

장점: 도메인 지식을 활용한 정교한 평가 가능

단점: 시간과 비용이 많이 들고, 평가자의 주관이 개입될 수 있음

적합한 경우: 테스트 케이스가 적거나(10~20개), 매우 전문적인 판단이 필요한 경우

2. 지표 기반 자동 평가하기

수치화된 기준으로 자동으로 평가하는 방식입니다. 이는 다시 두 가지로 나뉩니다.

2-1. 규칙 기반 평가

수학 공식처럼 명확한 기준으로 평가합니다.

- 예시: 이메일 카테고리 분류 시스템

- 정답: "광고"

- AI 출력: "광고"

- 평가: 일치 → 1점 / 불일치 → 0점

적합한 경우: 정답이 명확한 분류, 추출, 선택 작업

2-2. AI 심판 평가 (LLM-as-Judge)

또 다른 AI 모델이 평가자 역할을 합니다. 마치 법정에서 판사가 사건을 판단하듯, AI가 다른 AI의 결과물을 평가하는 거죠.

- 예시: 고객 응대 답변 품질 평가

- AI가 작성한 답변의 친절함, 정확성, 완결성을 1~5점 척도로 평가

- 평가 기준을 프롬프트로 상세히 제공

적합한 경우: 창의적 글쓰기, 요약, 번역 등 정성적 판단이 필요한 작업

실전 사례 1: 이메일 자동 분류 시스템 평가하기

개인 사업자가 매일 수십 통의 이메일을 받는다고 가정해봅시다. 일일이 확인하고 분류하는 데 하루 1시간씩 소요됩니다. 이를 자동화하기 위해 AI 에이전트를 만들었습니다.

시스템 구조

이메일 수신 → AI 분석 → 카테고리 분류 + 우선순위 지정

- 카테고리: 업무, 광고, 개인, 스팸

- 우선순위: 높음, 보통, 낮음

평가 프로세스 3단계

1단계: 테스트 데이터셋 구축

평가를 위해서는 "정답이 있는 샘플 데이터"가 필요합니다. 마치 학생 평가를 위해 정답지가 있는 시험 문제를 만드는 것과 같습니다.

테스트 데이터 예시:

| 이메일 제목 | 본문 요약 | 정답 카테고리 | 정답 우선순위 |

|---|---|---|---|

| "프로젝트 마감일 연장 요청" | 클라이언트의 일정 변경 요청 | 업무 | 높음 |

| "50% 할인 이벤트!" | 쇼핑몰 광고 | 광고 | 낮음 |

| "다음 주 회의 일정" | 내부 미팅 조율 | 업무 | 보통 |

권장사항:

- 최소 20~50개의 다양한 케이스 포함

- 실제 업무에서 발생 가능한 애매한 경우도 포함

- 정답을 명확히 정의 (팀 내 합의 필요)

2단계: 자동 평가 실행

테스트 데이터를 AI 시스템에 입력하고, 결과를 정답과 비교합니다.

평가 지표 설정:

카테고리 정확도 = (올바르게 분류한 이메일 수) / (전체 이메일 수)

우선순위 정확도 = (올바르게 지정한 우선순위 수) / (전체 이메일 수)

첫 번째 테스트 결과:

- 카테고리 정확도: 90% (10개 중 9개 정답)

- 우선순위 정확도: 60% (10개 중 6개 정답)

해석: 카테고리는 잘 분류하지만, 우선순위 판단에 문제가 있습니다. 스팸 메일에 "높음" 우선순위를 부여하는 등의 오류가 발견되었습니다.

3단계: 분석 및 개선

문제 원인 파악:

낮은 우선순위 정확도의 원인을 분석한 결과, AI에게 우선순위 판단 기준을 명확히 제시하지 않았다는 것을 발견했습니다.

개선 조치 1: 프롬프트 상세화

기존:

이메일을 분류하고 우선순위를 지정하세요.

카테고리: 업무, 광고, 개인, 스팸

우선순위: 높음, 보통, 낮음

개선:

이메일을 다음 기준에 따라 분류하세요.

[카테고리 정의]

- 업무: 회사 업무 관련, 클라이언트/파트너 커뮤니케이션

- 광고: 마케팅 메일, 프로모션, 뉴스레터

- 개인: 친구/가족 연락, 개인적 용건

- 스팸: 불법 광고, 피싱 의심 메일

[우선순위 판단 기준]

- 높음: 24시간 내 응답 필요, 중요한 의사결정 관련

- 보통: 1주일 내 확인 필요, 일반적 업무 진행

- 낮음: 참고용 정보, 광고, 긴급하지 않은 개인 메일

※ 스팸은 자동으로 "낮음" 우선순위 지정

재평가 결과:

- 우선순위 정확도: 60% → 70% (10% 개선)

여전히 아쉬운 수준입니다. 추가 개선이 필요합니다.

개선 조치 2: AI 모델 업그레이드

사용 모델을 GPT-4o-mini에서 GPT-4o로 변경했습니다.

- 비용: 약 3배 증가

- 처리 시간: 약 1.5배 증가

- 정확도 향상:

- 카테고리: 90% → 100%

- 우선순위: 70% → 90%

의사결정 포인트:

이메일 분류 작업의 가치를 고려했을 때, 하루 1시간(연간 250시간) 절약 효과가 비용 증가(월 약 $5 추가)보다 훨씬 크므로 모델 업그레이드를 확정했습니다.

실전 사례 2: 문서 기반 질의응답 시스템 평가하기

RAG(Retrieval-Augmented Generation, 검색 증강 생성) 시스템은 회사 내부 문서, 매뉴얼, 정책 등을 학습시켜 직원들의 질문에 답변하는 AI입니다. 예를 들어 "고객 환불 요청 시 처리 절차는?"이라는 질문에 회사 CS 매뉴얼을 참조해 답변하는 거죠.

RAG 시스템의 두 가지 평가 영역

RAG 시스템은 단순 분류와 달리 두 단계를 거칩니다:

- 검색 단계: 관련 문서 찾기

- 생성 단계: 찾은 문서로 답변 작성

따라서 두 가지를 모두 평가해야 합니다.

평가 지표 1: 답변 정확성 (Correctness)

평가 방법: AI 심판(LLM-as-Judge) 활용

[평가 기준]

5점: 완벽히 정확하고 완전한 답변

4점: 대체로 정확하나 사소한 누락 있음

3점: 부분적으로 정확, 중요 정보 일부 누락

2점: 부정확한 정보 포함

1점: 완전히 틀린 답변 또는 무관한 답변

테스트 예시:

- 질문: "고객이 배송 지연으로 환불 요청 시 처리 기한은?"

- 정답: "접수 후 3영업일 이내 검토, 승인 시 5영업일 이내 환불 처리"

- AI 답변: "접수 후 3일 이내 검토하며, 환불은 영업일 기준 5일 소요됩니다."

- AI 심판 평가: 4점 (내용은 정확하나 "영업일" 표현이 첫 부분에서 누락)

평가 지표 2: 문서 검색 관련성 (Retrieval Relevance)

왜 필요한가?

답변이 우연히 맞을 수도 있습니다(환각, Hallucination). 실제로는 엉뚱한 문서를 참조했는데 운 좋게 그럴듯한 답변이 나온 거죠. 이를 방지하려면 "올바른 문서를 참조했는가"를 별도로 평가해야 합니다.

평가 방법:

시스템이 참조한 문서 조각(chunk)들이 질문과 얼마나 관련 있는지 AI 심판이 평가합니다.

[평가 기준]

5점: 질문에 직접 답할 수 있는 정보 포함

3점: 관련은 있으나 직접적 답변은 어려움

1점: 질문과 무관한 내용

청크 크기(Chunk Size) 최적화 사례

초기 설정:

- 청크 크기: 1,000자

- 청크 간 오버랩: 200자

평가 결과:

- 답변 정확성: 3.2/5점

- 검색 관련성: 2.8/5점

문제 진단:

검색 관련성이 낮다는 것은 시스템이 질문과 관련 없는 문서 부분을 가져온다는 의미입니다. 청크가 너무 크면 불필요한 정보까지 포함되어 AI가 혼란스러워할 수 있습니다.

개선 조치:

- 청크 크기: 1,000자 → 500자로 축소

- 오버랩: 200자 → 100자로 조정

재평가 결과:

- 답변 정확성: 3.2 → 4.1점

- 검색 관련성: 2.8 → 4.3점

청크를 작게 나누니 더 정확한 부분만 검색되어 답변 품질이 크게 향상되었습니다.

지속적 모니터링: 실전 운영 데이터 활용하기

테스트 데이터로 초기 평가를 마쳤다면, 이제 실제 운영 단계입니다. 하지만 여기서 끝이 아닙니다.

실전 데이터 자동 수집 전략

시나리오: 직원들이 RAG 시스템에 실제로 질문을 합니다.

수집 프로세스:

1. 직원 질문 입력

2. AI 답변 생성

3. 질문-답변 쌍을 자동으로 데이터베이스에 저장

4. 주기적으로 (예: 매주) 샘플 추출하여 평가

장점:

- 실제 사용 패턴 반영

- 예상치 못한 질문 유형 발견

- 시간 경과에 따른 성능 변화 추적

구현 팁:

운영 모드와 평가 모드를 분기 처리합니다.

- 평가 모드: 테스트 데이터로 평가 지표 계산

- 운영 모드: 실제 사용자 요청 처리 + 데이터 수집

이렇게 하면 평가 기능이 실제 서비스에 영향을 주지 않으면서도, 운영 데이터를 지속적으로 축적할 수 있습니다.

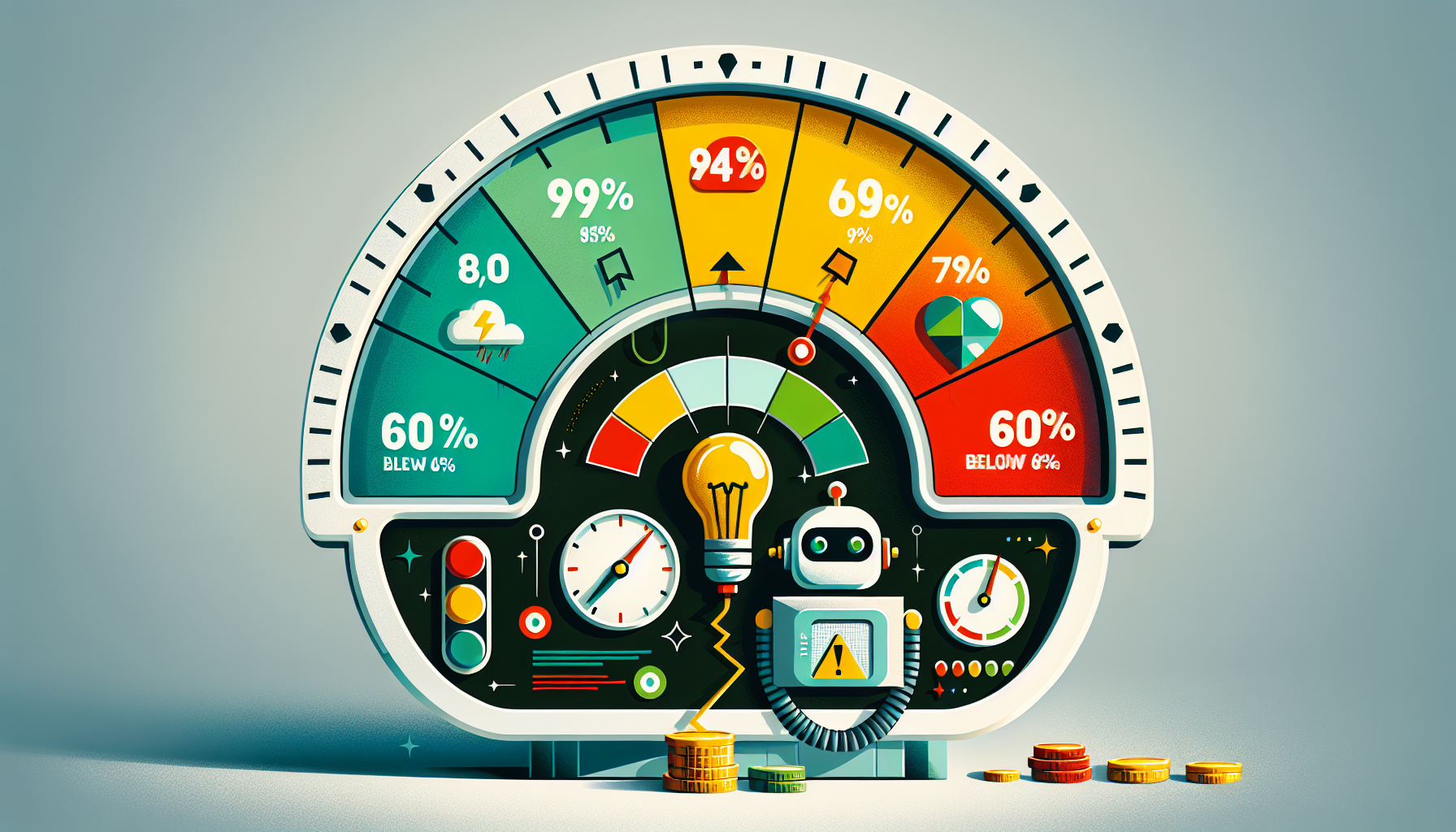

평가 결과 해석 및 액션 가이드

점수별 대응 전략

| 정확도 | 상태 | 권장 조치 |

|---|---|---|

| 95% 이상 | 우수 | 현재 설정 유지, 정기 모니터링 |

| 80~94% | 양호 | 세부 케이스 분석, 프롬프트 미세 조정 |

| 60~79% | 개선 필요 | 프롬프트 재작성 또는 모델 업그레이드 |

| 60% 미만 | 심각 | 전체 접근법 재검토, 전문가 투입 고려 |

일반적인 문제와 해결책

문제 1: 특정 카테고리만 계속 틀림

→ 해당 카테고리 정의를 더 명확히 하거나, 예시를 추가합니다.

문제 2: 처리 시간이 너무 오래 걸림

→ 더 빠른 모델로 교체하거나, 불필요한 처리 단계를 제거합니다.

문제 3: 비용이 예상보다 많이 나옴

→ 더 저렴한 모델로 테스트해보거나, 캐싱(이전 답변 재사용)을 도입합니다.

문제 4: 초기엔 좋았는데 시간이 지나며 성능 하락

→ 데이터 분포 변화 가능성. 최신 데이터로 재평가하고 프롬프트를 업데이트합니다.

평가 자동화 체크리스트

AI 시스템을 제대로 평가하려면 다음을 준비하세요.

사전 준비

- [ ] 평가 목적 명확화 (정확도? 속도? 비용 효율?)

- [ ] 최소 20개 이상의 테스트 케이스 준비

- [ ] 각 테스트 케이스에 정답 또는 평가 기준 정의

- [ ] 평가 지표 선정 (규칙 기반 vs AI 심판)

평가 실행

- [ ] 테스트 데이터를 시스템에 입력

- [ ] AI 출력 결과를 정답과 비교

- [ ] 평가 점수를 자동 계산하도록 설정

- [ ] 각 테스트 케이스별 상세 로그 기록

분석 및 개선

- [ ] 낮은 점수를 받은 케이스 집중 분석

- [ ] 패턴 파악 (특정 유형만 틀리는가?)

- [ ] 개선 조치 실행 (프롬프트 수정, 모델 변경 등)

- [ ] 재평가하여 개선 효과 확인

지속적 모니터링

- [ ] 실전 운영 데이터 자동 수집 설정

- [ ] 주간/월간 정기 평가 일정 수립

- [ ] 성능 저하 시 알림 설정

- [ ] 평가 결과 대시보드 구축

핵심 정리

- 감이 아닌 숫자로 판단하세요: AI 시스템의 성능은 정량적 지표로 측정해야 합니다. "잘 되는 것 같다"는 느낌은 위험합니다.

- 평가 방법은 작업 유형에 따라 선택하세요: 정답이 명확한 분류 작업은 규칙 기반, 정성적 판단이 필요한 작업은 AI 심판 방식을 사용합니다.

- 테스트 데이터는 실제 상황을 반영해야 합니다: 이상적인 케이스만이 아니라 애매하고 어려운 경우도 포함시켜야 실전에서 신뢰할 수 있습니다.

- 개선은 반복적 프로세스입니다: 평가 → 분석 → 개선 → 재평가 사이클을 반복하며 시스템을 점진적으로 최적화합니다.

- 실전 데이터를 지속적으로 수집하세요: 초기 테스트만으로 끝내지 말고, 운영 중인 시스템의 실제 성능을 계속 모니터링해야 합니다.

AI 에이전트는 한 번 만들고 끝나는 제품이 아닙니다. 지속적인 평가와 개선을 통해 진화하는 시스템입니다. 오늘 소개한 체계적 평가 방법을 적용하면, 여러분의 AI 시스템을 감이 아닌 데이터로 관리할 수 있습니다.